In Korean ‘Nvidia의 RTX와의 채팅 AI-기반 챗봇을 위한 재미있고 편리한 도구

Nvidia는 Chat with RTX라는 새로운 도구를 출시했습니다. 이 도구를 사용하면 사용자들은 오프라인에서 GenAI 모델을 실행하고 자신의 데이터로 사용자 정의할 수 있습니다.

Nvidia는 ENBLE이라는 새로운 도구를 소개했습니다. 이 도구를 사용하면 PC에서 GenAI 모델을 실행할 수 있습니다.

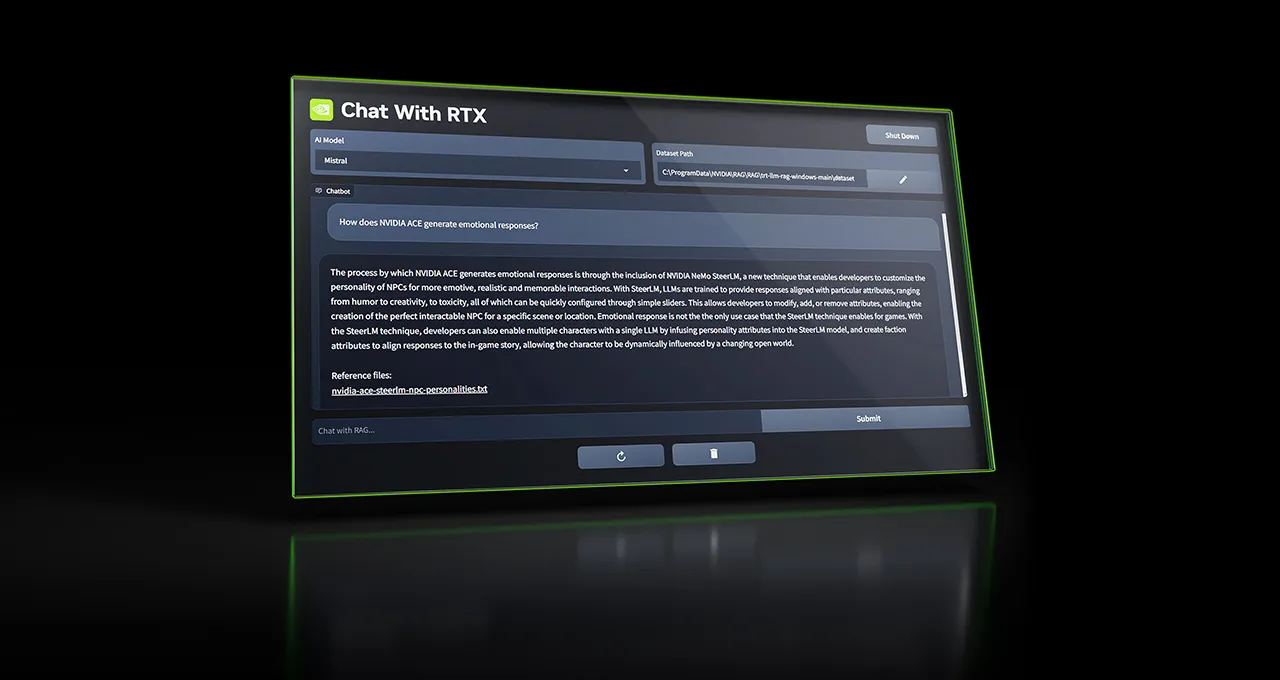

최신 GPU의 구매를 인센티브화하기를 항상 열망하는 Nvidia가 또 다른 흥미로운 상품을 선보입니다. 이 기술 거물은 Chat with RTX라는 도구를 출시하고 있습니다. 이 도구를 사용하면 GeForce RTX 30 시리즈 및 40 시리즈 카드 소유자가 Windows PC에서 오프라인으로 AI 기반 챗봇을 실행할 수 있습니다. 🎉

Chat with RTX로 맞춤 설정 및 간소화하기

Chat with RTX의 아름다움은 사용자가 OpenAI의 ChatGPT와 유사하게 GenAI 모델을 맞춤 설정하고 문서, 파일 및 노트에 연결할 수 있는 능력에 있습니다. 이렇게 함으로써 챗봇은 사용자의 질의를 받아들일 때 쉽게 답변과 정보를 제공할 수 있습니다. 메모지나 옛날 저장된 콘텐츠를 찾아 헤매지 않아도 되는 거죠!

예를 들어, 라스베이거스 여행 중 파트너가 추천한 음식점의 이름을 필사하려고 필사하고 있습니다. 뇌를 쥐어 짜거나 끝없는 파일을 찾아 헤맬 대신에, Chat with RTX에 질문을 그냥 입력하면 됩니다. “라스베이거스에서 파트너가 추천한 음식점이 어디었죠?”라고요. 이 지능형 챗봇은 사용자가 가리킨 로컬 파일을 검색하여 답을 제공할 것입니다. 관련 내용을 함께 제공하죠. 얼마나 편리한가요? 😮

Chat with RTX로 다양한 옵션 개척하기

Chat with RTX는 AI 스타트업 Mistral의 오픈소스 모델이 사전에 로드되어 있습니다. 그러나 Meta의 Llama 2와 같은 기타 텍스트 기반 모델도 지원합니다. 여러분은 필요에 맞는 모델을 선택하고 실험할 자유가 있습니다.

그러나 필요한 모든 파일을 다운로드하는 것은 상당한 저장 공간을 소비할 수 있다는 점을 명심하십시오. 선택한 모델에 따라 50GB에서 100GB의 여유 공간이 필요할 수 있습니다. 따라서 PC에 충분한 공간이 있는지 확인하십시오. 📁💻

- Memorizer는 영화와 책을 추적하고 창의성을 높여주는 앱입니다! | ENBLE

- 🤖 AI 휴대폰 봇? Cambio가 은행 세계를 혁신하고 있습니다! 📞

- Mindy 이메일 기반의 행정 보조자 📧💼

다재다능한 챗봇

Chat with RTX는 현재 텍스트, PDF, .doc, .docx 및 .xml과 같은 다양한 파일 형식과 함께 작동합니다. 이러한 지원되는 파일을 포함한 폴더를 앱에 가리키면 해당 모델의 세부 조정 데이터 세트에 로드할 수 있습니다. 그리고 이것이 전부가 아닙니다! YouTube 재생목록의 URL을 제공하면 챗봇은 해당 재생목록의 동영상 트랜스크립션을 로드합니다. 이 기능을 사용하여 선택한 모델을 사용하여 비디오의 내용을 질의할 수 있습니다. 다양성에 대하여 얘기하는 겁니다! 📚📽️📑

제한과 개선의 여지

Nvidia는 Chat with RTX의 사용자들에게 현실적인 기대를 가지도록 하려고 합니다. 이 앱에는 약간의 제한 사항이 있으므로 염두에 두셔야 합니다. 먼저, 챗봇은 문맥을 기억할 수 없습니다. 이는 책임있는 재질 응답을 선택적으로 처리하지 않습니다. 예를 들어, “북미의 일반적인 새는 무엇인가요?”라고 묻고 “그 새의 색깔은 무엇인가요?”라는 후속 질문을 한다면, Chat with RTX는 이 두 가지 질문을 연결하고 새에 대한 얘기를 하는 것으로 이해하지 못합니다. 이는 다소 작은 약점입니다. 🤷♂️

Nvidia는 또한 챗봇의 응답의 타당성이 여러 가지 요인에 의해 영향을 받을 수 있다고 인정하고 있습니다. 이에는 질문의 어구, 선택한 모델의 성능 및 세부 조정 데이터 세트의 크기 등이 포함됩니다. 특정 문서에서 다루는 정보를 요청하는 것은 일반적으로 더 나은 결과를 제공합니다. 또한 응답 품질은 대규모 데이터 세트와 함께 향상되는 경향이 있습니다. 따라서 Chat with RTX가 정확하고 상세한 답변을 제공하도록 하려면 해당 주제에 대한 견고한 데이터 세트를 갖도록 해야 합니다. 📊📈📖

Chat with RTX는 그야말로 재미있고 유용한 장난감보다는 프로덕션 사용을 위한 도구보다 더 가깝다는 것을 언급할 가치가 있습니다. 그러나 이와 같은 도구들은 AI 모델을 로컬에서 보다 더 접근 가능하고 사용 가능하게 만드는 성장하는 추세에 기여합니다. 세계경제포럼은 오프라인에서 실행되는 GenAI 모델이 저렴한 장치들에서 “급격히” 증가할 것으로 예측하고 있습니다. 이는 PC, 스마트폰, 사물인터넷(IoT) 장치 및 네트워킹 장비 등을 포함합니다. 이러한 오프라인 모델은 명확한 장점을 제공합니다. 처리하는 데이터는 장치를 떠나지 않기 때문에 개인 정보 보호 측면에서 보다 더 안전합니다. 또한 지연 시간이 더 낮고 비용 효율적인 편입니다. 🌍💪💻

인공 지능 모델의 미래: 이익과 위험의 균형 잡기

물론 모델 실행 및 훈련을 위한 도구를 민주화하는 것은 잠재적인 남용에 대한 우려를 낳습니다. 빠른 구글 검색으로 알 수 있듯이, 웹의 부도덕한 구석에서 유해한 콘텐츠에 대해 세밀하게 조정된 많은 모델들을 찾아볼 수 있습니다. 그러나 지지자들은 Chat with RTX와 같은 앱의 이점이 위험을 상쇄한다고 주장합니다. 어떤 기술적 진보든지 그것은 적정한 균형을 찾는 문제입니다. 시간이 지날 때 어떻게 이 추세가 펼쳐지고 잠재적인 위험을 완화할 수 있는지 알게 될 것입니다.👀⚖️

전반적으로, Chat with RTX는 Nvidia의 도구 라인업에 흥미로운 추가입니다. AI 챗봇의 힘을 손끝으로 가져오며 맞춤화와 사용 편의성을 제공합니다. 제한 사항이 있을 수도 있지만, AI를 보다 접근 가능하고 오프라인에서 사용할 수 있는 방향으로의 한 걸음입니다. 따라서 기술 애호가이든 편리한 도구를 찾고 있는 개인이든 Chat with RTX는 분명히 시도해볼 가치가 있습니다! 💬💡

Q&A

Q: Chat with RTX는 context를 기억할 수 있나요?

A: 불행히도, 이 앱은 context를 기억하지 못합니다. 이는 후속 질문에 대한 답변 시 이전 질문을 고려하지 않을 것을 의미합니다. 각 질문은 독립적으로 처리됩니다.

Q: Chat with RTX는 어떤 종류의 파일을 지원하나요?

A: Chat with RTX는 현재 텍스트, PDF, .doc, .docx, .xml 파일 형식을 지원합니다. 따라서 이러한 유형의 파일을 챗봇의 세밀하게 조정된 데이터셋에 쉽게 로드하여 정보를 질의할 수 있습니다.

Q: 선택한 모델의 성능은 챗봇의 응답의 관련성에 영향을 미치나요?

A: 예, 선택한 모델의 성능은 챗봇의 응답의 관련성에 영향을 미칩니다. 그러나 질문의 구문이나 세밀하게 조정된 데이터셋의 크기와 같은 다른 요소들도 Chat with RTX가 제공하는 답변의 정확성과 유용성에 기여합니다.

Q: Chat with RTX를 위해 얼마나 많은 저장 공간이 필요한가요?

A: Chat with RTX를 위해 필요한 저장 공간은 선택한 모델에 따라 다릅니다. 50GB에서 100GB 정도의 범위일 수 있습니다. 필요한 파일들을 수용하기 위해 PC에 충분한 여유 공간이 있는지 확인하세요.

미래를 전망하며

Chat with RTX와 같은 도구의 등장으로 오프라인에서 작동하는 AI 모델의 미래는 유망해 보입니다. 세계 경제 포럼에 따르면, GenAI 모델을 오프라인에서 처리할 수 있는 저렴한 장치의 크게 증가할 것으로 예상됩니다. 이러한 변화는 개인 정보 보호 개선부터 지연 시간 감소 및 비용 효율성까지 여러 이점을 가져옵니다. 기술이 계속 발전함에 따라 다양한 기기 및 산업에서 오프라인 AI 모델과 그 응용 분야에 대한 더 많은 발전을 기대할 것입니다. 흥미로운 시기가 기다리고 있습니다!🚀🌌

참고 자료: – Researchers unlocked ChatGPT – Kusari building supply chain security platform (Top Open Source) – Llama 2